El ascenso de los robots asesinos

Por Yassamine Mather

También conocemos al fabricante de armas turco, STM, que en 2017 reveló su producción del Kargu, un dron asesino totalmente autónomo del tamaño de una pelota de rugby. Los drones Kargu también se basan en el reconocimiento de imágenes y rostros para atacar a sus víctimas. Se cree que tales drones se usaron en Libia en 2020 para atacar selectivamente objetivos. Una vez más, según Russell, “STM es un fabricante relativamente pequeño en un país que no es líder en tecnología. Así que hay que asumir que hay programas en marcha en muchos países para desarrollar estas armas”.

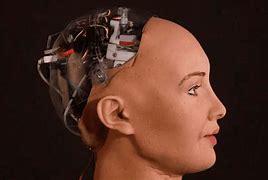

La mayoría de las armas de IA incorporan una serie de tecnologías de IA, incluida la percepción visual, de sonido y el reconocimiento facial, la comparación en grandes bases de datos, así como herramientas de toma de decisiones para realizar una variedad de operaciones militares aéreas, terrestres y marítimas, todo esto independiente de la intervención o incluso la supervisión humana.

Además está la categoría de ‘munición de ataque merodeadora’ (LAM loitering attack munitions). Estas armas están preprogramadas para merodear en busca de objetivos (en otras palabras, buscan aviones, barcos o tanques enemigos) para ser identificados por sensores que detectan el radar de defensa aérea del enemigo. Los LAM usan tecnología de inteligencia artificial para derribar proyectiles atacantes, reaccionan mucho más rápido que cualquier operador humano y pueden permanecer en vuelo (o merodear) durante períodos de tiempo mucho más largos.

El Harpy II de Israel es un LAM que puede permanecer en vuelo hasta seis horas, y también hay una serie de armas LAM totalmente autónomas desarrolladas por el Reino Unido, China, Alemania, India, Israel, Corea del Sur, Rusia…

En una reciente conferencia de la ONU, celebrada en diciembre de 2021 en Ginebra, quedó claro que varios gobiernos, incluidos EEUU, Israel, Rusia, el Reino Unido y Australia, están en contra de la prohibición de tales armas. Sorprendentemente, China parece estar a favor de su prohibición, y el embajador chino en la Conferencia de desarme de NNUU, Li Song, dijo que la aplicación de la tecnología de IA puede desempeñar un papel importante en el futuro de la guerra, con la posibilidad de causar grandes crisis humanitarias: “hacen falta reglas para que no se conviertan en un instrumento de guerra o hegemonía”. 2

Por supuesto, China es muy consciente de la intransigencia de EEUU en este tema y simplemente hace tales afirmaciones para mantener la ‘superioridad moral’. De hecho, ya sabemos que los drones aéreos y marítimos de China están conectados a redes neuronales complicadas, que podrían monitorear y controlar las aguas del Mar del Sur de China. Se podrían usar para impedir en el futuro la ‘libertad de navegación’ estadounidense en esta zona. Pero está claro que la administración Biden no apoyará una prohibición legalmente vinculante del desarrollo de máquinas de guerra autónomas no tripuladas (o ‘robots de guerra asesinos’), favoreciendo en cambio un ‘código de conducta’ no vinculante.

Peligros

Todos conocemos los errores y los posteriores desastres causados por los drones operados por humanos, por lo que es fácil imaginar cómo las acciones de los ‘robots asesinos’ autónomos pueden salirse de control.

Entre los expertos en ética de IA que han expresado una considerable cautela sobre tales dispositivos se encuentra John Tasioulas, profesor de Oxford y director del Instituto de Ética aplicada a la IA, quien tuiteó que la postura de la administración Biden era “triste y poco sorprendente”. 3

El video Slaughterbots de 2017 brinda una representación precisa de armas pequeñas preparadas para utilizar IA: drones del tamaño de un pájaro que apuntan a una víctima específica o a un conjunto de víctimas. Están programados para disparar una pequeña cantidad de explosivos al cráneo del objetivo. La defensa o interceptación de armas tan pequeñas es muy difícil.

Hoy tales armas son razonablemente baratas y ya no son ciencia ficción. La próxima etapa en su desarrollo es, al parecer, ‘enseñarles’ cómo formar un ejército y trabajar en equipo. En esta y otras aplicaciones de IA, el comportamiento grupal de hormigas y abejas se estudia y aplica a dispositivos autónomos, para que actúen en coordinación entre sí. Imagine unos cientos de miles de estos dispositivos atacando una ciudad. En teoría podrían matar a la mitad de los habitantes sin dañar la infraestructura.

Se dice que los robots de IA cuestan mucho menos que contratar a un asesino y que no habría que sacrificar vidas humanas (no hay necesidad de terroristas suicidas). Pero está el complicado tema de la rendición de cuentas. ¿Quién es responsable? ¿La persona que dio la orden, la que programó el robot, el fabricante? Todo esto crea un campo minado, en lo que respecta al derecho internacional.

Según Stuart Russell,

“Las capacidades de las armas autónomas estarán más limitadas por las leyes de la física, por ejemplo, por restricciones de alcance, velocidad y carga útil, que por cualquier deficiencia en los sistemas de inteligencia artificial que las controlan. Es concebible el despliegue de estas plataformas por millones, cuya agilidad y letalidad dejarán a los humanos completamente indefensos”. 4

Si tales predicciones son correctas, las armas de IA podrían ser más peligrosas que la amenaza que representan las armas nucleares, que las regulaciones internacionales, incluido el Tratado de no proliferación, supuestamente limitan. Aunque Israel no forma parte, todos los demás países con armamento nuclear se han adherido al TNP y se enfrentan a controles e inspecciones periódicas. Además, las armas nucleares supuestamente son solo un elemento de disuasión, porque todo el mundo sabe que la guerra nuclear entre las principales potencias nucleares conduciría inevitablemente a la destrucción mutua.

Cuando se trata de armas de IA, ha habido varias propuestas para evitar un desastre potencial. Por ejemplo, algunos expertos en IA y asesores militares han sugerido usar algún tipo de solución de ‘freno humano en el circuito’. Por supuesto, sabemos que la toma de decisiones humanas no ha salvado la vida de víctimas inocentes de los drones en Afganistán o en el Medio Oriente. Sin embargo, para los fervientes defensores de las armas de IA, la principal ventaja de sus nuevos juguetes letales proviene de la velocidad y la supuesta precisión de dichos dispositivos que funcionan sin intervención humana.

Otros han propuesto ‘regulaciones’ para controlar las armas de IA, pero esto no ha ido muy lejos. Para empezar, no está muy claro qué se puedan catalogar como un arma totalmente automatizada. Según Heather Roff, de la Facultad de Derecho de la Universidad Case Western Reserve, el armamento autónomo de IA consiste en “sistemas de armas, capaces de aprender y adaptar su ‘funcionamiento en respuesta a circunstancias cambiantes en el entorno en el que [están] desplegados’, así como como capaces de tomar decisiones de ataque por sí mismos”. 5

Algunos académicos utilizan un umbral mucho más bajo para clasificar como un arma autónoma cualquier sistema de armas capaz de causar la muerte sin supervisión humana, mientras que el Ministerio de Defensa británico tiene otra definición:

“Aquellos sistemas que son capaces de comprender la intención y dirección de alto nivel. A partir de esta comprensión y su percepción del entorno, dicho sistema es capaz de tomar las decisiones adecuadas para lograr el estado deseado. Es capaz de decidir un curso de acción, a partir de una serie de alternativas, sin depender de la supervisión y el control humanos; sin embargo, la implicación humana con el sistema aún puede estar presente. Si bien la actividad general de una aeronave autónoma no tripulada será predecible, es posible que las acciones individuales no lo sean”. 6

Está además la cuestión de quién supervisaría las regulaciones sobre las armas de IA. Se dice que solo se permitiría que los robots luchen contra robots, y por lo tanto se evitarían los “daños colaterales”. Pero es difícil imaginar que los Estados imperialistas se sometan a tales regulaciones. Durante una guerra, el objetivo suele ser infligir el máximo daño, que incluye bajas humanas.

¿Prohibición?

Una propuesta, apoyada por muchos académicos y científicos, es el llamamiento de la Campaña para Detener los Robots Asesinos de prohibir todas las armas de IA. No hay nada nuevo en tal petición: biólogos, químicos y físicos han hecho campaña durante mucho tiempo contra las armas biológicas, químicas y nucleares. Sin embargo, muchos Estados, incluidos EEUU, Reino Unido y Rusia, se oponen a tal prohibición, alegando que es prematura en relación con el armamento de IA.

En febrero de 2021, la Comisión de Seguridad Nacional de Inteligencia Artificial de EEUU apoyó el desarrollo de armas autónomas impulsadas por software de IA. Robert Work, ex subsecretario de defensa y miembro del panel, afirmó que las armas autónomas cometerían menos errores que los humanos, por ejemplo, al reducir las bajas causadas por la identificación errónea de objetivos.

Entonces, ¿cuál es la situación actual en esta materia? ¿Quién está ganando esta guerra hasta ahora?

En la carrera armamentista actual, China no es el desvalido y hay predicciones de que pronto superará a los EEUU. Ello se debe principalmente a su superioridad en lo que respecta a los datos necesarios para alimentar los algoritmos de aprendizaje automático. En 2018, el presidente chino, Xi Jinping, ya enfatizó la importancia de los “grandes datos”, el almacenamiento en la nube y las comunicaciones cuánticas entre las “áreas más avanzadas y prometedoras para la fusión civil-militar”, y el gobierno chino proporcionó una gran cantidad de fondos para estos proyectos.

Los científicos que abogan por la prohibición de las armas de IA señalan lo siguiente:

*Esta tecnología tendrá un efecto negativo en el futuro de la humanidad porque aumentará las incertidumbres que plantean las amenazas existentes, como el armamento nuclear; transformará la naturaleza de estas amenazas e introducirá otras nuevas.

*La perspectiva de fusionar la IA con los sistemas de alerta temprana comprimirá y reducirá drásticamente el marco de tiempo para la toma de decisiones.

*La ubicuidad y la disminución de los costes de los drones significarán que estas armas seguirán proliferando a una velocidad sin precedentes. En La era de la IA: y nuestro futuro humano, Eric Schmidt advierte sobre los peligros de los sistemas de IA de aprendizaje automático, argumentando que se están desarrollando tan rápido que podrían reaccionar a los misiles hipersónicos disparando armas nucleares antes de que cualquier humano tome la decisión.

*Las armas autónomas complicarán la capacidad de los Estados para anticipar, atribuir y contrarrestar de manera efectiva futuros ataques autónomos.

En la situación actual, es fácil ver cómo los países más pobres ya han perdido cualquier posibilidad de hacer frente a tales amenazas. Si a EEUU no le gusta la política exterior de algún ‘Estado canalla’, no necesitará organizar un golpe: en su lugar, puede desplegar armas de IA con algoritmos de reconocimiento facial para eliminar a todos los miembros ‘antipáticos’ de ese gobierno.

En agosto de 2018, el presidente de Venezuela, Nicolás Maduro, afirmó que había sobrevivido a un intento de asesinato con drones explosivos. Aunque esto no se puede confirmar de forma independiente, las imágenes de su discurso en un evento que marcaba el 81 aniversario del Ejército nacional muestran al presidente de repente mirando hacia arriba, parece sobresaltado, y decenas de soldados huyen. Venezuela culpó a elementos opositores en EEUU de instigar “un complot de derechas”.

Es fácil imaginar una situación en la que, en lugar de aplicar sanciones, EEUU emplee armas de inteligencia artificial para destruir la infraestructura civil y militar de un “Estado canalla”, mientras afirma que no hay “daños colaterales”.

En diciembre de 2021, un robot de IA, el Megatron Transformer, llenó los titulares cuando se utilizó como orador en un debate en Oxford Union, en una moción titulada: “Esta casa cree que la IA nunca será ética”. El Megatron llegó a una conclusión muy interesante:

“La IA nunca será ética. Es una herramienta y, como toda herramienta, se usa para bien y para mal. No existe una buena IA, solo humanos buenos y malos. Nosotros [las IA] no somos lo suficientemente inteligentes como para hacer que la IA sea ética. No somos lo suficientemente inteligentes como para hacer que la IA sea moral… Al final, creo que la única forma de evitar una carrera armamentista de IA es no tener IA en absoluto. Esta será la última defensa contra la IA”. 7

Notas

- www.ft.com/content/03b2c443-b839-4093-a8f0-968987f426f4 . ↩︎

- www.scmp.com/news/china/military/article/3159704/time-set-global-rules-ai-warfare-china-tells-un-weapons-review . ↩︎

- www.independent.co.uk/news/world/americas/us-politics/biden-killer-war-robots-ban-b1972343.html . ↩︎

- www.nature.com/articles/521415a . ↩︎

- core.ac.uk/download/pdf/214077458.pdf . ↩︎

- www.gov.uk/government/publications/unmanned-aircraft-systems-jdp-0-302 . ↩︎

- www.bbc.co.uk/news/technology-59687236 . ↩︎

Fuente: https://weeklyworker.co.uk/worker/1378/rise-of-the-killer-machines/

Traducción: Enrique García

sinpermiso.info/textos/el-ascenso-de-los-robots-asesinos